Вступление

В следующем руководстве описывается, как вручную настроить зеркалирование дисков (RAID1) в операционной системе Windows.

Поскольку на серверах, которые были установлены с помощью нашей автоматической установки Windows (доступной через робота ) или заказанных с помощью надстройки Windows, уже настроен и запущен уровень RAID 1, это руководство предназначено для пользовательских установок Windows.

Подготовка

- Сначала щелкните значок

Windows symbolв нижнем левом углу или нажмите клавишуWindowsилиSuper. - Введите

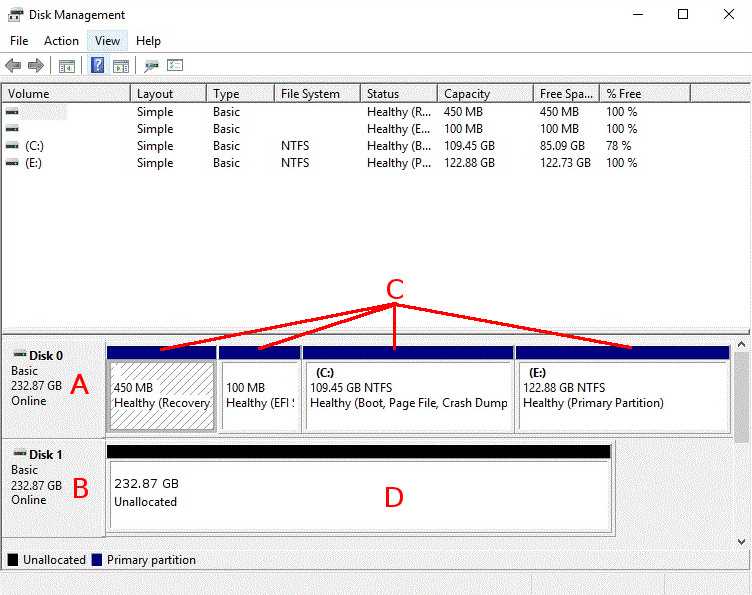

diskmgmt.mscи нажмитеEnterклавишу, чтобы открыть Утилиту управления дисками.Ниже приведен краткий обзор утилиты:

- A: Основной диск, содержащий операционную систему

- B: Второй диск, предназначенный для использования для зеркалирования RAID1

- C: Тома (означают разделы под Windows) на основном диске

- D: Незанятое пространство на втором диске

- Если на вашем втором диске уже есть тома, щелкните их правой кнопкой мыши и выберите

Delete Volumeвсе из них. - Щелкните правой кнопкой мыши диск, который в настоящее время содержит операционную систему, и щелкните

Convert to dynamic disk. - В появившемся диалоге уже должен быть выбран главный диск. Пожалуйста, выберите также другой диск, который вы хотите использовать для RAID1, нажмите

Okи подтвердите. - Теперь вам нужно определить, была ли ваша система установлена в устаревшем режиме или в режиме UEFI. Поэтому щелкните значок

Windows symbolв нижнем левом углу или нажмите клавишуWindowsилиSuper. - Введите

msinfo32.exeи нажмитеEnterклавишу, чтобы открыть окно информации о системе. - На правой панели вы должны увидеть

BIOS MODEзапись, в которой в качестве значения указан режим рассмотрения (LegacyилиUEFI). Если указанная запись отсутствует, система установлена вLegacyрежиме. Затем перейдите к разделу, касающемуся данной статьи.

Наследие

Если ваша система работает в устаревшем режиме, следующие шаги должны быть выполнены на всех томах основного диска слева направо:

- Щелкните правой кнопкой мыши соответствующий объем и выберите

Add mirroringиз контекстного меню. - В появившемся меню выберите предпочтительный второй диск для RAID1 и подтвердите, нажав на

Add mirroring.

Убедитесь, что все тома были добавлены к зеркалированию и синхронизация запущена, на что указывают тома красного цвета и информация об их состоянии.

UEFI

Каждая система UEFI имеет так называемый системный том UEFI. Этот раздел не может быть автоматически зеркалирован Windows, и его необходимо вручную скопировать и настроить на втором диске. Как и в случае с Legacy, добавляйте зеркальное отображение для томов один за другим слева направо.

- Для всех томов, которые не имеют

EFIметки, выполните эти шаги:- Щелкните правой кнопкой мыши соответствующий объем и выберите

Add mirroringиз контекстного меню. - В появившемся меню выберите предпочтительный второй диск для RAID1 и подтвердите это, нажав

Add mirroring.

- Щелкните правой кнопкой мыши соответствующий объем и выберите

- Для системного тома UEFI выполните следующие действия:

- Создайте системный том UEFI того же размера на втором диске и отформатируйте его с помощью FAT32 . Поэтому просто щелкните правой кнопкой мыши незанятое пространство второго диска, выберите

New Simple Volumeи следуйте диалогу. - Скопируйте данные системного тома UEFI с первого диска на второй. Поэтому рекомендуем загрузить сервер в Rescue System и подключиться к нему по SSH:

- Найдите соответствующие разделы:

parted -lЭта команда выведет список разделов всех дисков. Найдите там два раздела UEFI на обоих дисках, которые вы можете определить по их размеру и файловой системе ( FAT32 ), и объедините идентификаторы дисков (/dev/sdX) с соответствующими номерами разделов.Пример:parted -l Model: WD Enterprise P20691 Disk /dev/sda: 2000GB Sector size (logical/physical): 512B/512B Partition Table: msdos Disk Flags: Number Start End Size Type File system Flags 1 1049kB 101MB 100MB primary fat32 2 102MB 2000GB 1999GB primary ntfs Model: WD Enterprise P20691 Disk /dev/sda: 2000GB Sector size (logical/physical): 512B/512B Partition Table: msdos Disk Flags: Number Start End Size Type File system Flags 1 1049kB 101MB 100MB primary fat32 2 102MB 2000GB 1999GB primary ntfsВ данном случае это разделы/dev/sda1и/dev/sdb1. - Создайте папки точек монтирования:

mkdir /mnt/main mkdir /mnt/second - Установите соответствующие разделы системы UEFI (замените разделы на свои):

mount -t vfat /dev/sda1 /mnt/main -o rw,umask=0000 mount -t vfat /dev/sdb1 /mnt/second -o rw,umask=0000 - Затем скопируйте все файлы из текущего системного раздела UEFI в новый:

cp -ar /mnt/main/ /mnt/second/ - После завершения загрузите сервер обратно в установленную систему:

reboot

- Найдите соответствующие разделы:

- После повторного открытия Утилиты управления дисками (см. Раздел «Подготовка» данного руководства) вы также можете добавить системный том UEFI к зеркалированию, щелкнув его правой кнопкой мыши и выбрав

Add mirroringиз контекстного меню. - В появившемся меню выберите предпочтительный второй диск для RAID1 и подтвердите, нажав на

Add mirroring.

- Создайте системный том UEFI того же размера на втором диске и отформатируйте его с помощью FAT32 . Поэтому просто щелкните правой кнопкой мыши незанятое пространство второго диска, выберите

Убедитесь, что все тома были добавлены к зеркалированию и синхронизация запущена, на что указывают тома красного цвета и информация об их состоянии.

Если у вас возникнут проблемы с определенными томами или второй Plex (означает, что часть зеркального тома Microsoft) не является загрузочным, см. Официальную документацию .